本文字数统计:4147 字

在当今互联网时代,无论是企业还是个人,都需要有一个网站来宣传自己的品牌和产品。然而,在这个网络世界里,只有拥有良好的流量才能让你的网站真正的脱颖而出。而Robots协议则是网站优化中不可或缺的一部分。本文将为你详细介绍Robots协议在优化中的重要性。

Robots协议是什么

Robots协议,也叫爬虫协议或机器人协议,是一种存放在网站根目录下的文本文件,用于告诉搜索引擎蜘蛛哪些页面可以被访问,哪些页面不允许被访问。

Robots协议的作用

Robots协议的主要作用就是控制搜索引擎蜘蛛的抓取行为,可以指定搜索引擎蜘蛛访问哪些页面,哪些页面不允许被访问。同时也可以设置一些特殊的参数,如抓取时间间隔等。

Robots协议与SEO优化

在SEO优化中,Robots协议也起着非常重要的作用。通过设置Robots协议,可以使搜索引擎更快地索引网站,并且更好地理解网站结构,提高网站在搜索引擎中的排名。

Robots协议中的关键字

在Robots协议中,可以使用一些关键字来告诉搜索引擎蜘蛛该怎样抓取网站内容,比如noindex、nofollow等,这些关键字对于搜索引擎排名和用户体验都有很大影响。

如何编写Robots协议

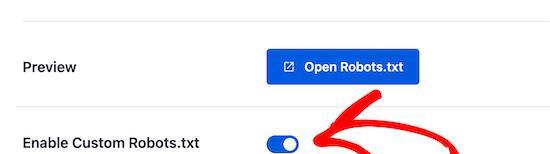

编写Robots协议并不是一件很困难的事情。首先需要了解协议格式和语法规则,然后根据自己的网站需求进行设置。同时也可以使用一些开源的工具来生成Robots协议文件。

常见的Robots协议错误

在编写Robots协议时,如果出现错误可能会导致搜索引擎无法正确地抓取网站内容。一些常见的错误包括格式错误、关键字设置错误等。

Robots协议与爬虫协议

在一些场合下,人们将Robots协议与爬虫协议混淆起来。其实这两者是完全不同的概念。爬虫协议是指规定爬虫抓取网页的规则和方法,而Robots协议则是规定哪些页面可以被访问,哪些页面不允许被访问的协议。

Robots协议与安全性

在一些安全性要求比较高的网站中,也需要使用Robots协议进行设置。可以设置不允许搜索引擎抓取某些敏感信息页面,保证网站信息安全。

如何测试Robots协议是否生效

在设置完Robots协议之后,需要测试是否生效。可以使用一些在线工具来测试是否能够正确地抓取页面,如googleSearchConsole等。

总结

Robots协议在网站优化中非常重要,可以帮助搜索引擎更好地抓取页面,并提高网站在搜索引擎中的排名。同时也需要注意格式、关键字等设置是否正确,并进行定期的测试和优化。

下载

下载

下载

下载

类型:卡牌游戏 大小: 13.3M

类型:休闲益智 大小: 29.2M

类型:卡牌游戏 大小: 421.7M

类型:休闲益智 大小: 121.9M

类型:卡牌游戏 大小: 2.4M

类型:卡牌游戏 大小: 2.6M