本文字数统计:6897 字

本文目录一览

- 1、

- 2、

Robots协议的重要性与应用

越来越多的网站被创建和更新、随着互联网的发展。Robots协议成为了必不可少的一部分、为了让搜索引擎更好地索引和显示网站的内容。本文将重点介绍Robots协议在网站排名优化和风险控制中的应用。

Robots协议是什么?

Robots协议的作用

Robots协议的语法格式

Robots协议的指令解析

Robots协议的User-agent指令

Robots协议的Disallow指令

Robots协议的Allow指令

Robots协议的Sitemap指令

Robots协议的Crawl-delay指令

Robots协议的Noindex指令

Robots协议的Nofollow指令

Robots协议的使用注意事项

Robots协议对SEO的影响

Robots协议对风险控制的作用

Robots协议的未来发展趋势

我们可以看到它在网站排名优化和风险控制中的作用和重要性,通过对Robots协议的介绍。提高网站的排名和安全性,希望本文能够帮助读者更好地了解和使用Robots协议。

Robots文件的作用及配置方法

它可以帮助我们优化网站SEO、同时也可以保护网站的安全,Robots文件是一个很重要的文件。我们将会介绍Robots文件的作用以及如何配置Robots文件,在这篇文章中。

Robots文件是什么

它位于网站根目录下,Robots文件是一个文本文件。哪些页面可以被访问,该文件用于告诉搜索引擎蜘蛛,哪些页面不能被访问。可以控制搜索引擎蜘蛛对网站的抓取行为、通过Robots文件。

Robots文件的作用

1.优化网站SEO

哪些页面需要被忽略,我们可以告诉搜索引擎哪些页面是最重要的、Robots文件可以帮助我们优化网站SEO、通过Robots文件。

2.保护网站安全

Robots文件还可以帮助我们保护网站的安全。从而保护网站的安全、通过Robots文件、我们可以阻止搜索引擎访问敏感页面。

如何配置Robots文件

1.创建Robots文件

你需要在网站的根目录下创建一个名为,要创建一个Robots文件“txt,robots”的文本文件。

2.编辑Robots文件

只需要使用文本编辑器打开该文件、然后按照需要进行编辑即可,编辑Robots文件的方法很简单。

3.上传Robots文件

需要将该文件上传至网站的根目录下,编辑完Robots文件后。

Robots文件的语法规则

1.Robots文件的语法规则

Robots文件遵循一定的语法规则,具体规则如下:

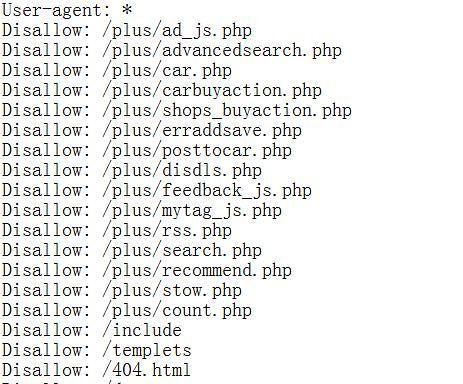

(1)User-agent

User-Baiduspider等,agent指的是搜索引擎蜘蛛的名称、如googlebot。

(2)Disallow

多个页面之间可以用,Disallow指的是禁止搜索引擎访问的页面“|”隔开。

(3)Allow

同样多个页面之间可以用,Allow指的是允许搜索引擎访问的页面“|”隔开。

2.Robots文件的示例

以下是一个简单的Robots文件示例:

User-agent:*

Disallow:/admin/

Disallow:/cgi-bin/

Disallow:/tmp/

Allow:/index.html

Robots文件常见问题解答

1.Robots文件的错误会影响SEO吗?

因为搜索引擎蜘蛛可能会无法正常抓取页面,Robots文件的错误会影响网站的SEO。

2.Robots文件能否完全阻止搜索引擎蜘蛛访问页面?

因为某些搜索引擎蜘蛛可能会忽略Robots文件中的规则,Robots文件不能完全阻止搜索引擎蜘蛛访问页面。

3.如何查看Robots文件是否生效?

可以通过搜索引擎的网站管理员工具来查看Robots文件是否生效。

4.如何禁止搜索引擎蜘蛛访问整个网站?

可以在Robots文件中使用“User-agent:*”和“Disallow:/”来禁止搜索引擎蜘蛛访问整个网站。

我们了解到了Robots文件的作用以及如何配置Robots文件、通过本文的介绍。因此我们应该重视Robots文件的配置,Robots文件对于优化网站SEO和保护网站安全都有很大的作用。

下载

下载

下载

下载

类型:模拟经营 大小: 70.7M

类型:飞行射击 大小: 23.0M

类型:飞行射击 大小: 142.1M

类型:休闲益智 大小: 48.4M

类型:休闲益智 大小: 49.1M

类型:休闲益智 大小: 54.1M