本文字数统计:4471 字

越来越多的网站面临着蜘蛛的抓取和爬取,还会对网站的安全带来潜在风险、随着互联网技术的发展,这些无效流量不仅会给网站带来访问压力。如何有效屏蔽蜘蛛对网站的抓取成为了很多网站管理员需要关注和解决的问题。

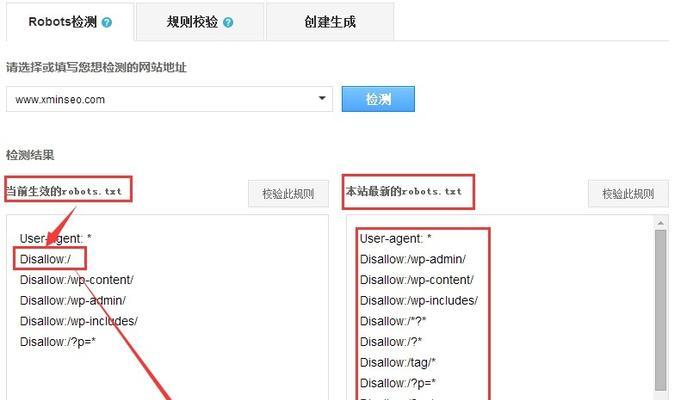

设置robots.txt文件

txt文件可以限制搜索引擎爬虫访问网站的范围和方式,通过设置robots,从而达到屏蔽蜘蛛的目的。txt文件时,在设置robots,需要注意以下几点:(1)确保文件位置正确;(2)使用正确的语法格式;(3)不要将重要页面列入禁止访问范围。

使用meta标签

可以通过在网页头部添加meta标签告诉搜索引擎不要对页面进行索引和跟踪,meta标签也是一个有效的屏蔽蜘蛛的方式。使用meta标签屏蔽蜘蛛对网站的抓取并不能完全保证网站的安全性、需要注意的是。

添加Disallow指令

txt文件中用于禁止搜索引擎爬虫访问某些特定页面或目录的指令、Disallow指令是robots。同时也有助于提高网站的安全性,添加Disallow指令可以有效地屏蔽蜘蛛对网站的抓取。

使用人机验证

可以在一定程度上防止恶意程序对网站进行爬取和攻击、人机验证是一种能够辨别人类和计算机程序差异的技术。需要根据实际情况选择合适的验证方式和级别,在设置人机验证时。

开启防火墙

避免被恶意程序攻击和破坏,开启防火墙可以有效地保护网站的安全。减轻服务器负担,同时,防火墙也能够过滤掉无效流量,提高网站访问速度。

限制IP访问

从而防止恶意程序进行攻击和爬取,限制IP访问可以屏蔽某些特定IP地址对网站的访问。需要注意确保自己的IP地址没有被误判为非法地址、在设置IP限制时。

加密传输协议

加密传输协议(HTTPS)是一种通过SSL/TLS协议对网络数据进行加密传输的协议。防止被恶意程序窃取和攻击,使用HTTPS可以有效地保护网站数据安全。

使用CDN加速服务

提高访问速度,从而减轻服务器负担、CDN加速服务可以将网站内容分发到多个节点上。提高网站安全性,同时、CDN也能够过滤掉无效流量。

屏蔽蜘蛛对网站的抓取是每个网站管理员都需要关注和解决的问题。IP限制,meta标签,Disallow指令,txt文件,通过合理使用robots、HTTPS和CDN等技术手段可以有效地屏蔽无效流量和提高网站安全性,防火墙,人机验证。

下载

下载

下载

下载

类型:模拟经营 大小: 70.7M

类型:飞行射击 大小: 23.0M

类型:飞行射击 大小: 142.1M

类型:休闲益智 大小: 48.4M

类型:休闲益智 大小: 49.1M

类型:休闲益智 大小: 54.1M